목차

Deep Neural Network

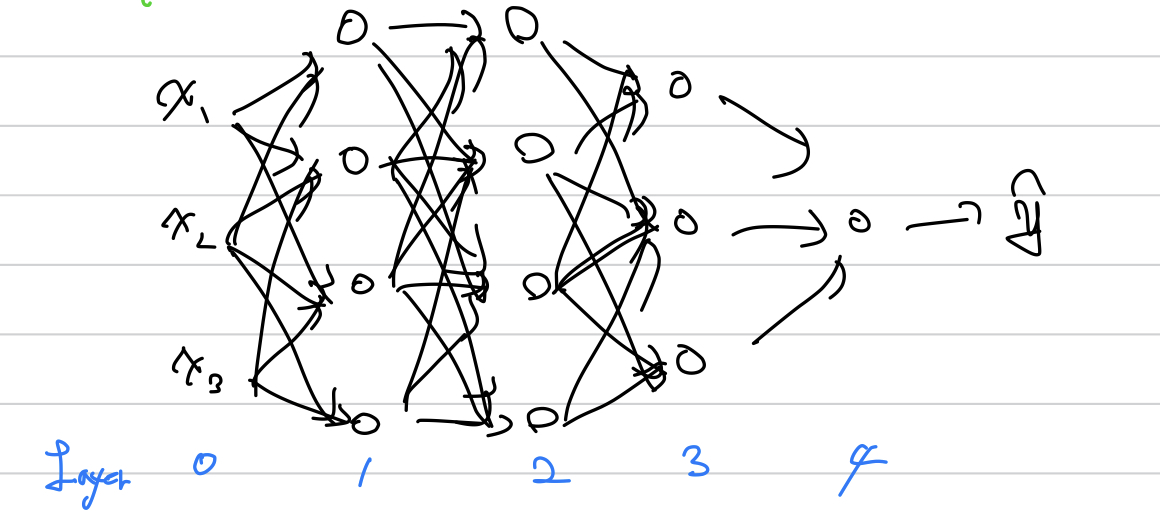

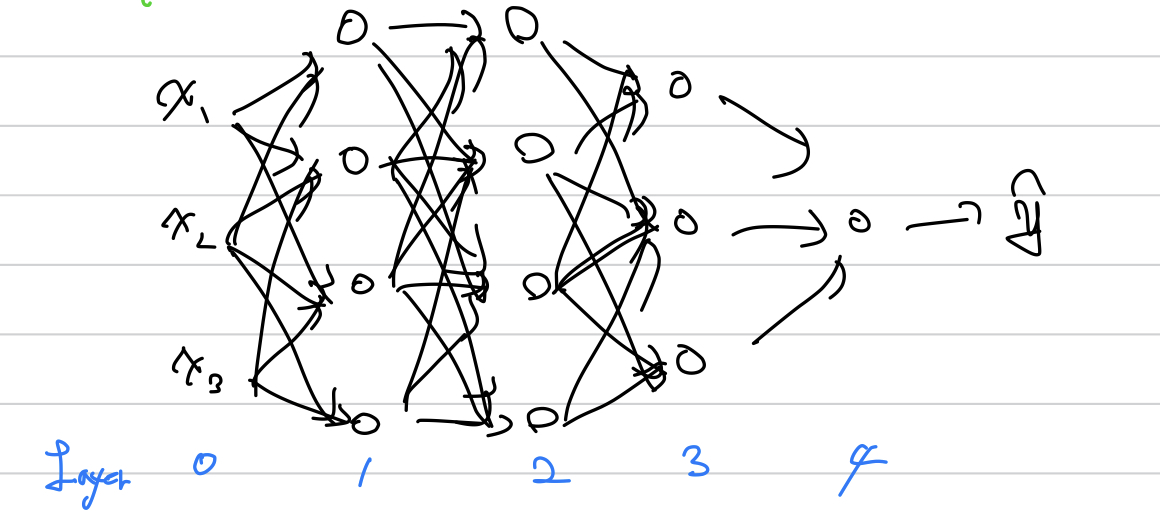

저번에는 Shallow Neural Network를 살펴봤는데, 이젠 좀 더 깊게 만들어보자

$$ L = 4 (#Layers) $$

$$ n^{[l]} = #units in layers l $$

$$ a^{[l]} = activation in layer l $$

$$ a^{[l]} = g^{[l]}(z^{[l]}) $$

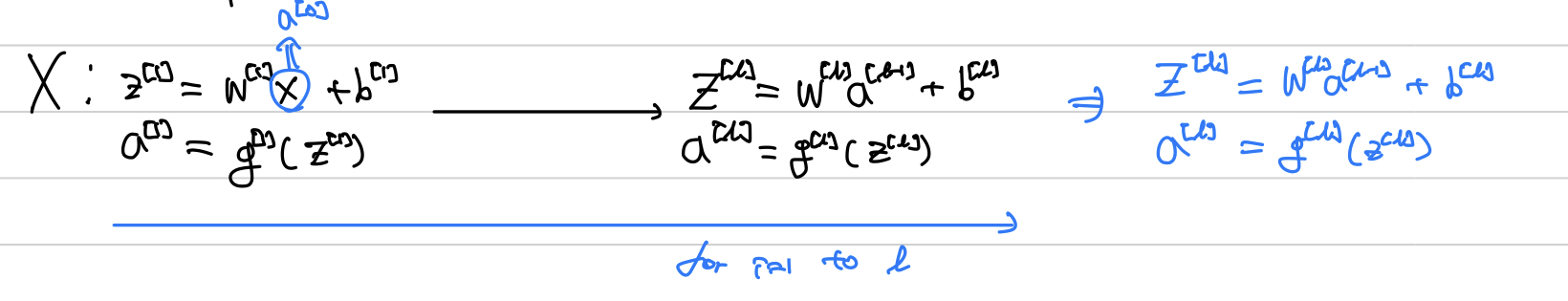

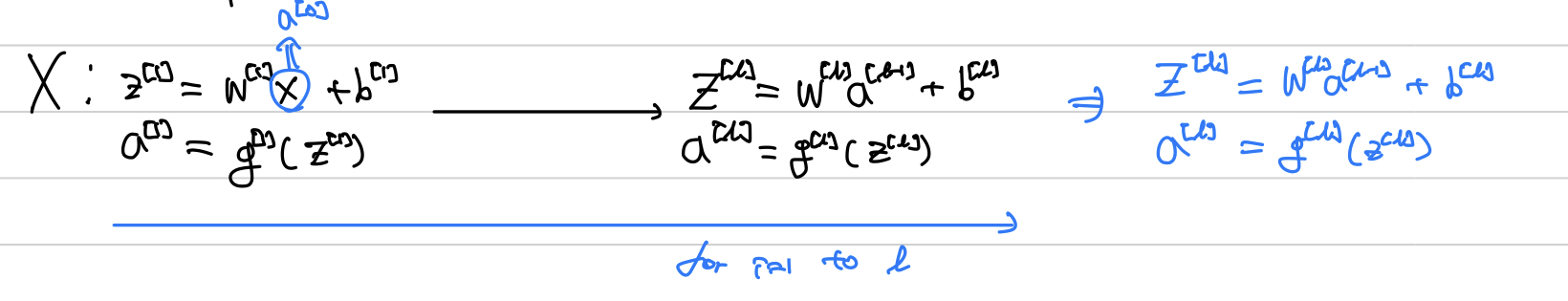

Forward propagation in Deep Neural Network

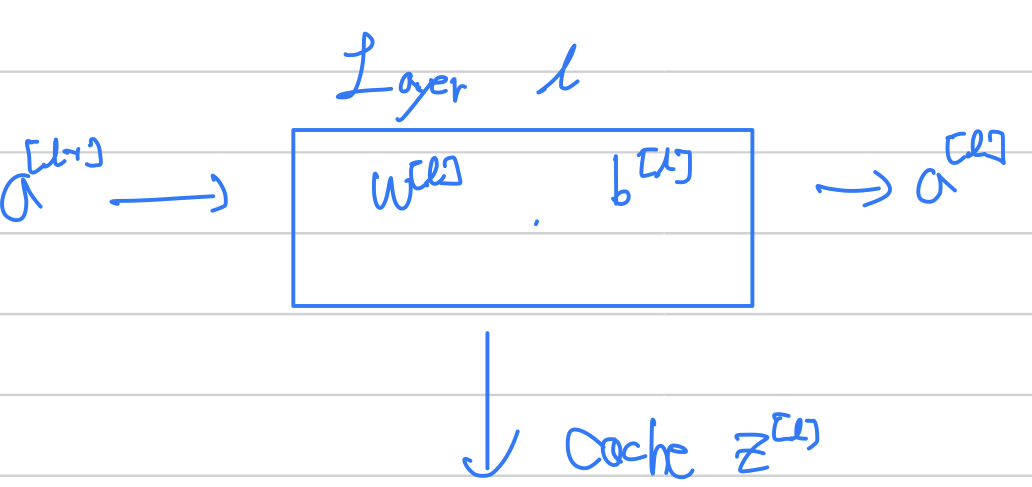

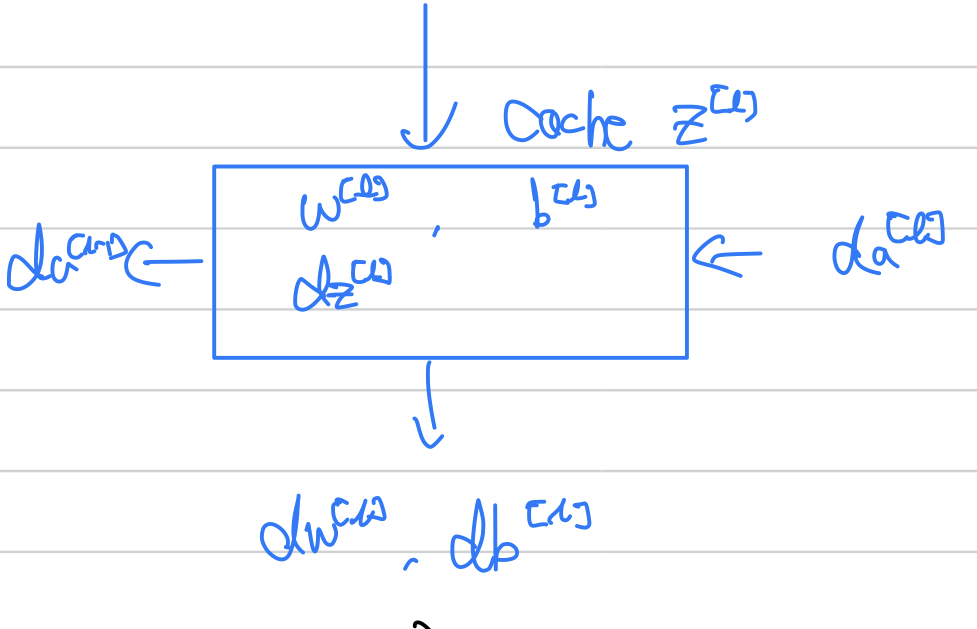

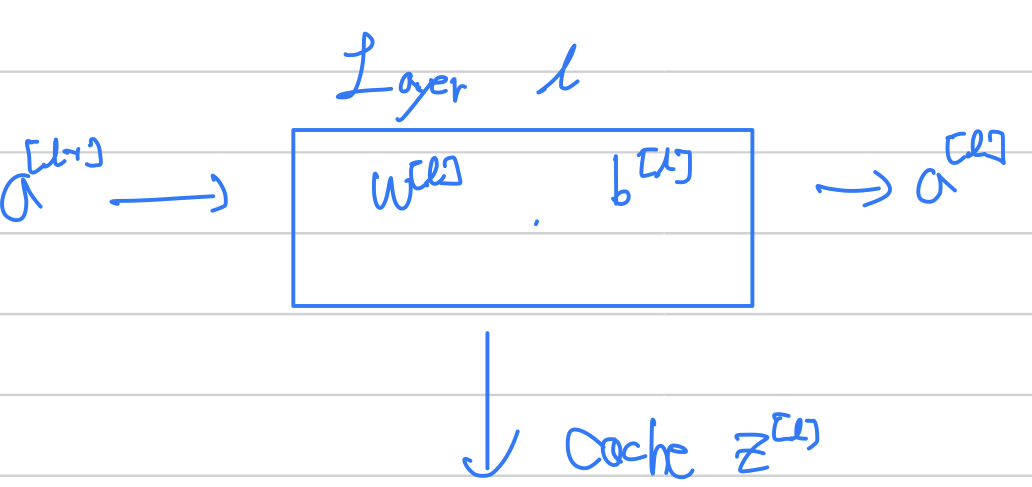

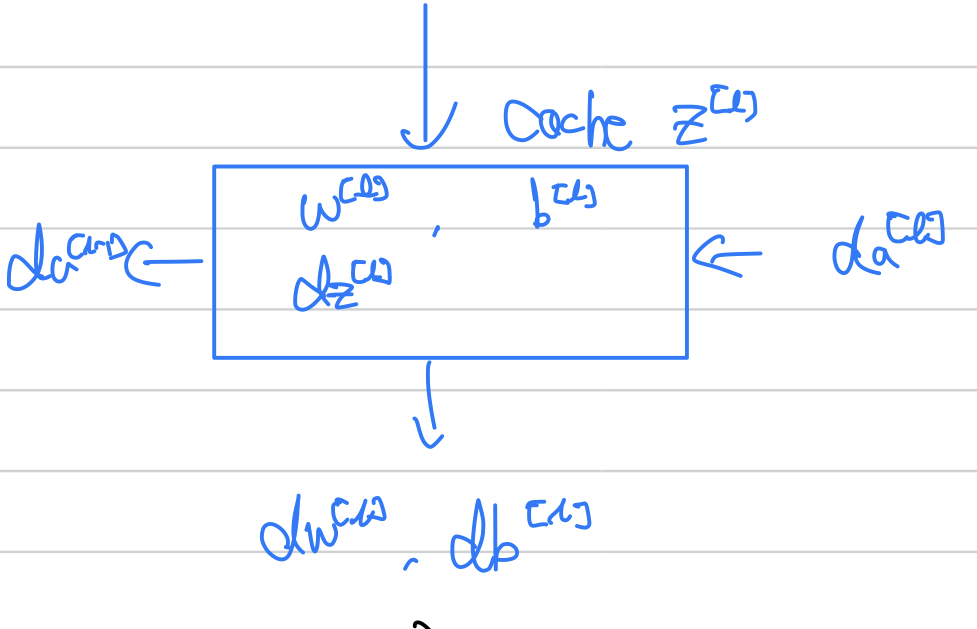

Building Blocs of Neural Network

$$ Layer l : w^{[l]}, b^{[l]} $$

$$ Forward => Input: a^{[l-1]}, Output: a^{[l]} $$

$$ z^{[l]} = W^{[l]}a^{[l-1]} + b^{[l]} $$

$$ a^{[l]} = g^{[l]}(z^{[l]}) $$

back propagation때 사용할 z를 여기서 임시로 저장해둔다

$$ Backword => Input: da^{[l]}, Output: da^{[l-1]}, dw^{[l]}, db^{[l]} $$

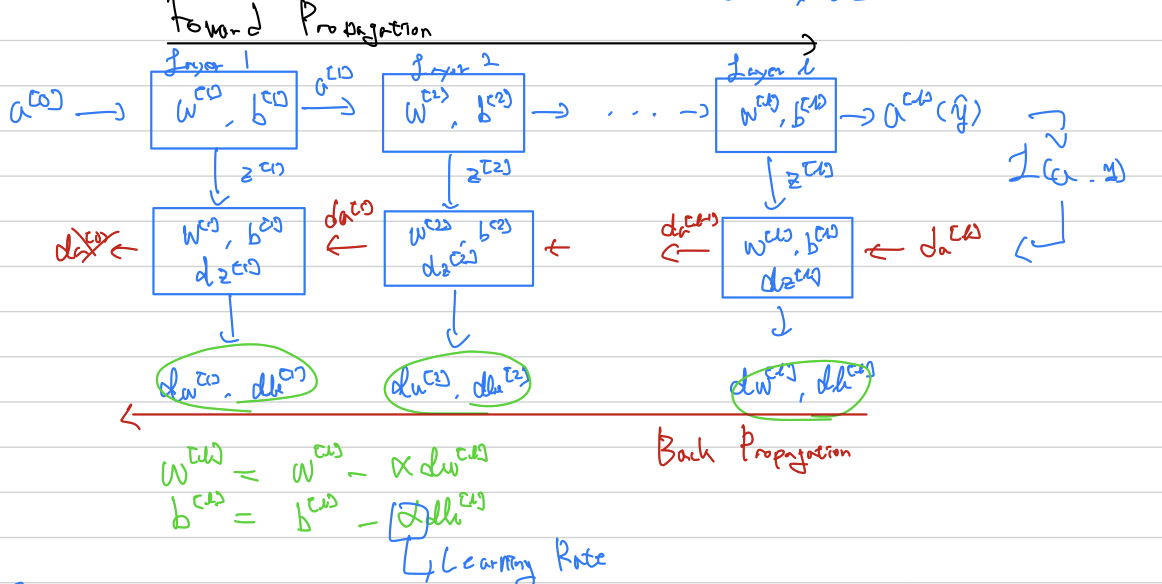

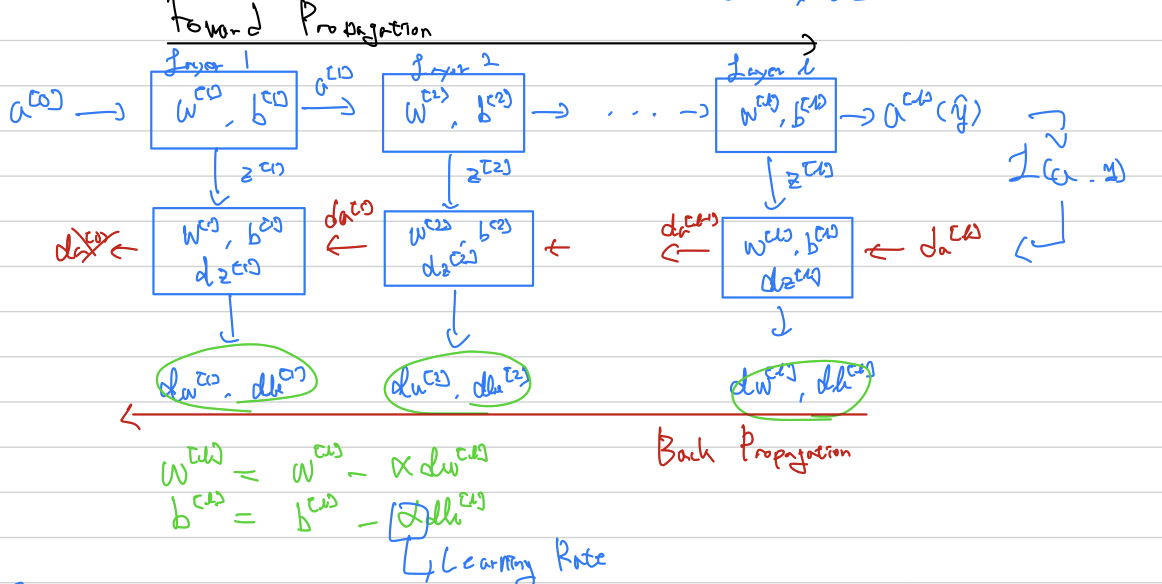

총과정의 그림

Parameter, HyperParameter

학습 시킬 데이터를 Parameter

Parameter

$$ w^{[1]}, b^{[1]}, w^{[2]}, b^{[2]} ... $$

직접 학습 시킬 데이터다. 이 parameter들이 학습된다.

HyperParameter

- Learning Rate

- #iteration

- #hidden layers L

- #hidden units n[1], n[2]...

- Activation Function

...

따로 부족한 부분이나 틀린점, 오타 지적은 댓글로 부탁드려요!

'부트캠프,프로그램 > Google ML Bootcamp' 카테고리의 다른 글

| 구글 머신러닝 부트캠프 2주차(1/3) (2) | 2022.09.02 |

|---|---|

| 구글 머신러닝 부트캠프 1주차(3/4) (0) | 2022.08.22 |

| 구글 머신러닝 부트캠프 1주차(2/4) (0) | 2022.08.03 |

| 구글 머신러닝 부트캠프 1주차(1/4) (0) | 2022.08.03 |

목차

Deep Neural Network

저번에는 Shallow Neural Network를 살펴봤는데, 이젠 좀 더 깊게 만들어보자

$$ L = 4 (#Layers) $$

$$ n^{[l]} = #units in layers l $$

$$ a^{[l]} = activation in layer l $$

$$ a^{[l]} = g^{[l]}(z^{[l]}) $$

Forward propagation in Deep Neural Network

Building Blocs of Neural Network

$$ Layer l : w^{[l]}, b^{[l]} $$

$$ Forward => Input: a^{[l-1]}, Output: a^{[l]} $$

$$ z^{[l]} = W^{[l]}a^{[l-1]} + b^{[l]} $$

$$ a^{[l]} = g^{[l]}(z^{[l]}) $$

back propagation때 사용할 z를 여기서 임시로 저장해둔다

$$ Backword => Input: da^{[l]}, Output: da^{[l-1]}, dw^{[l]}, db^{[l]} $$

총과정의 그림

Parameter, HyperParameter

학습 시킬 데이터를 Parameter

Parameter

$$ w^{[1]}, b^{[1]}, w^{[2]}, b^{[2]} ... $$

직접 학습 시킬 데이터다. 이 parameter들이 학습된다.

HyperParameter

- Learning Rate

- #iteration

- #hidden layers L

- #hidden units n[1], n[2]...

- Activation Function

...

따로 부족한 부분이나 틀린점, 오타 지적은 댓글로 부탁드려요!

'부트캠프,프로그램 > Google ML Bootcamp' 카테고리의 다른 글

| 구글 머신러닝 부트캠프 2주차(1/3) (2) | 2022.09.02 |

|---|---|

| 구글 머신러닝 부트캠프 1주차(3/4) (0) | 2022.08.22 |

| 구글 머신러닝 부트캠프 1주차(2/4) (0) | 2022.08.03 |

| 구글 머신러닝 부트캠프 1주차(1/4) (0) | 2022.08.03 |